Dall’avvento dei Big Data ci troviamo a gestire non solo una grande quantità di dati, ma anche dati con differenti caratteristiche e formati. Il Data Lake ("Lago dei dati") è ciò che semplifica l'archiviazione di questo corpus sempre più eterogeneo di dati. Saperlo padroneggiare vuol dire migliorare l'analisi e la gestione dei dati in azienda. In che modo? Scopriamolo in quest'articolo, realizzato dall’Osservatorio Big Data & Business Analytics del Politecnico di Milano.

I limiti dei modelli tradizionali di Business Intelligence

Partiamo da un presupposto: l’evoluzione dei dati è stata sì in termini di volume, ma anche di velocità e varietà. Per gestire i dati le architetture tradizionali di Business Intelligence si sono rivelate inadatte per due principali motivi:

- Integrazione: se nei decenni scorsi poteva essere considerato normale creare dei silos di dati, separati per ogni funzione aziendale, questa configurazione architetturale non permette di sfruttare il potenziale dei Big Data. Integrare quanti più dati possibili è fondamentale per ricercare pattern nascosti e relazioni tra diverse fonti, al fine di estrarre informazioni utili alle decisioni di business.

- Eterogeneità di formato: i dati che possono e devono essere valorizzati non sono soltanto quelli aziendali, i cosiddetti dati transazionali. L’estrazione degli insight può anzi essere abilitata dall’integrazione di dati con formati eterogenei, come per i dati web, social, provenienti dai sensori, o addirittura a dati destrutturati, quali immagini, testi o video. Le architetture tradizionali di storage non abilitano l’immagazzinamento di dati semi-strutturati o de-strutturati.

Che cos’è il Data Lake?

Con il termine Data Lake, letteralmente “lago dei dati”, ci si riferisce ad un ambiente di archiviazione dei dati nel loro formato nativo, fin quando non è necessario dar loro una struttura.

Si tratta, in termini più tecnici, dell’applicazione del cosiddetto schema on-read (che si contrappone al più tradizionale schema on-write), in cui lo schema dei dati viene fornito nel momento dell’analisi e non nel momento dell’archiviazione. Per comprendere questo punto si pensi allo schema predefinito di un database relazionale, che lascia invece il posto a un semplice contenitore di informazioni. Grazie a questa modalità di gestione è possibile avere l’integrazione di elevate quantità di dati di qualsiasi formato e provenienti da qualsiasi fonte, in maniera molto più agile e scalabile.

Va sottolineato che non sempre l’adozione di un Data Lake porta ad abbandonare soluzioni più tradizionali (ad esempio il Data Warehouse, che raccoglie dati provenienti dai sistemi operazionali aziendali con altri dati provenienti invece da fonti esterne). Anzi, la configurazione più matura è proprio rappresentata da un modello integrato, dove si valorizzano le informazioni disponibili attraverso l’interconnessione tra dati strutturati e non.

Perché adottare un Data Lake? Tutti i vantaggi

L’Osservatorio Big Data & Business Analytics ha raccolto negli anni molte testimonianze di aziende che hanno deciso di evolvere la propria infrastruttura, a partire proprio dalla costruzione di un Data Lake. V sottolineato che in molti di questi casi il Cloud Computing si è rivelato un elemento fortemente abilitante per dar vita a soluzioni scalabili e velocizzare il deployment dello strumento.

Varietà e integrazione dei dati

Il vantaggio principale di adottare un unico repository di tutti i dati, in forma grezza, sta nella possibilità di correlare differenti fonti e tipologie. Questa evoluzione, dunque, all’apparenza strettamente tecnologica può essere il principale elemento abilitante per lo sviluppo di una cultura data-driven in azienda.

Questo è ad esempio stato il caso di , che a partire dall’evoluzione tecnologica supportata da partner esterni ha poi dato vita a una struttura di Data Science interna all’azienda.

Analisi dati più veloce e scalabile

Inoltre, la scalabilità e la velocità d’analisi che un’infrastruttura basata su un Data Lake permette di raggiungere sono estremamente superiori. È il caso di La Rinascente, in cui un progetto di rinnovamento infrastrutturale avviato nel 2018 permette oggi di integrare diversi terabyte di dati, sia raccolti in modalità batch sia con flussi in tempo reale, e – attraverso opportuni strumenti di front-end, quindi di reportistica e visualizzazione – metterli a disposizione degli utenti di business con dashboard interattive.

Il Data Lake per l'integrazione dati: dove si trovano le grandi aziende?

Per quanto riguarda le grandi aziende italiane, gli ultimi dati dell’Osservatorio sul tema mostrano come siano ancora la minoranza le aziende che hanno costruito un Data Lake (circa un’azienda su tre), mentre le restanti organizzazioni utilizzano Data Warehouse tradizionali o sistemi legacy, dove i dati sono suddivisi in Silos che non comunicano tra di loro.

Anche laddove esistono sistemi di storage di dati non strutturati (database di nuova generazione quali NoSQL o NewSQL), non sempre questi sono in comunicazione con il Data Warehouse aziendale. La sfida dell’integrazione rimane quindi una delle più difficili da superare, soprattutto se le analisi si basano anche su dati esterni (web, social, sensori, open data ecc…).

Oltre il Data Lake: il Data Lakehouse e il Data Hub

Negli ultimi anni, si è assistito a una significativa evoluzione nel panorama della gestione dei dati, con il passaggio dal concetto di Data Lake a nuovi approcci come il Data Lakehouse e Data Hub.

Negli ultimi anni, si è assistito a una significativa evoluzione nel panorama della gestione dei dati, con il passaggio dal concetto di Data Lake a nuovi approcci come il Data Lakehouse e Data Hub.

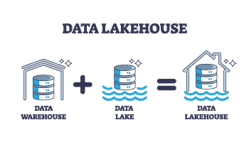

Il Data Lake, inizialmente adottato per la sua capacità di accogliere grandi volumi di dati eterogenei, ha mostrato alcuni limiti nell'organizzazione, nella governance e nell'accesso efficiente ai dati. Questa consapevolezza ha dato vita al concetto di Data Lakehouse, una soluzione che integra flessibilità e convenienza di un Data Lake con la struttura dati e le funzionalità Data Warehouse. Il Data Lakehouse cerca, dunque, di fornire una struttura più organizzata, con schemi predefiniti e controlli di qualità dei dati, consentendo al contempo l'analisi in tempo reale e l'accesso semplificato alle informazioni.

Parallelamente, ha guadagnato terreno il concetto di Data Hub, rappresentando un approccio architetturale più distribuito e interoperabile alla gestione dei dati.

Un Data Hub funge da punto centrale per la raccolta, l'archiviazione e la distribuzione di dati provenienti da diverse fonti, facilitando la condivisione e la collaborazione tra le diverse unità aziendali.

Questo approccio mira a creare un ecosistema flessibile in cui i dati possono essere utilizzati in modo collaborativo, promuovendo la coerenza e la sicurezza nella gestione delle informazioni.

Vuoi comprendere come integrare i Big Data per la tua Data Strategy aziendale?

- Autore

Ricercatrice Senior degli Osservatori Big Data & Business Analytics e Artificial Intelligence

Gli ultimi articoli di Irene Di Deo

-

Cosa fa il Chief Data Officer: ruolo e responsabilità 21 marzo 2025

-

Data Lake, significato e vantaggi per l'analisi dei dati 12 gennaio 2024

-

Data Integration, cos'è e come fare integrazione dei dati 12 gennaio 2024

Potrebbe interessarti

Le 5V dei Big Data: dal Volume al Valore

Articoli più letti